🤯⚡️Det är din skyldighet att slappa på jobbet

En avslappnad hjärna kommer på värdefullare lösningar. Detta förändrar ju allt!

Det här är nyhetsbrevet där Tomas Seo, innovationsstrateg på Phorecast, berättar om händelser, upptäckter och ny teknik som får honom att utbrista: Detta förändrar ju allt! Du prenumererar på det här för att fortsätta vara steget före med de senaste trenderna och få konkreta tips för att framtidssäkra dig och din organisation. Har du fått det här av en vän? Då vill du kanske starta en egen prenumeration?

Vad har hänt?

- Receptet på den smartaste typen av AI-modeller är nu fritt tillgängligt

Varje vecka släpps det AI-modeller som inte är lika bra som de bästa och därför inte speciellt intressanta för människor utanför AI-bubblan. Men nya AI-modellen Sky-T1-32B-Preview som släpptes i fredags har nyhetsvärde inte för att den kan mäta sig som lika bra som en tidigare version av o1, utan för att det är den första resonemangsmodellen som släpps med helt öppen källkod och träningsdata.

Senaste generationens högpresterande chattbottar har gått ifrån strukturen att du frågar och får svar direkt till att de först genererar en inre monolog som vi inte ser men som ändå påverkar resultatet. Genom att modellerna är tränade på att generera inre monolog så får modellen mer kontext och kan därför i slutändan leverera bättre resultat.

Vad NovaSky, en forskargrupp från UC Berkeleys Sky Computing Lab, har gjort är att de har tagit en befintlig open source-modell och finjusterat den med träningsdata så den först genererar tankar om uppgiften innan lösningen genereras. Enligt forskarna tog det bara 19 timmar och en budget på mindre än 450 dollar att träna modellen, men då måste man förstå att de fortfarande utgick ifrån en befintlig modell (Alibabas QwQ-32B-Preview) som i sin tur uppskattningsvis kostat några miljoner att träna.

När vi går igenom Sky-T1s fine-tuning träningsprompter så innehåller alla samma setup:

"system": "Your role as an assistant involves thoroughly exploring questions through a systematic long thinking process before providing the final precise and accurate solutions. This requires engaging in a comprehensive cycle of analysis, summarizing, exploration, reassessment, reflection, backtracing, and iteration to develop well-considered thinking process. Please structure your response into two main sections: Thought and Solution. In the Thought section, detail your reasoning process using the specified format: <|begin_of_thought|> {thought with steps separated with '\n\n'} <|end_of_thought|> Each step should include detailed considerations such as analisying questions, summarizing relevant findings, brainstorming new ideas, verifying the accuracy of the current steps, refining any errors, and revisiting previous steps. In the Solution section, based on various attempts, explorations, and reflections from the Thought section, systematically present the final solution that you deem correct. The solution should remain a logical, accurate, concise expression style and detail necessary step needed to reach the conclusion, formatted as follows: <|begin_of_solution|> {final formatted, precise, and clear solution} <|end_of_solution|> Now, try to solve the following question through the above guidelines:"(om du läste allt det där kanske du uppmärksammade att de stavat ”analisying”, det verkar de gjort konsekvent i alla tusentals tränings-exemplen, men när jag testade modellen så ville den ändå inte gå med på att analysing kan stavas så där.)

Deras modell kommer därför alltid att först generera en inre monolog som är Thought och därefter en Solution baserad på de tankarna. Genom att träna modellen på en mängd exempel på hur en fråga från en användare först genererar tankar och sedan exemplifiera hur de tankarna påverkar vilket svar som blir lämpligast så kan moderna resonerande AIs ge bättre svar utan att behöva träna en dyr grundmodell. I och med att hela receptet släpps helt öppet så kan alla som vill lära sig hur man själv kan skapa nästa generations smartare AI.

Detta förändrar ju allt

Det är inte alla människor en inre röst som de kan höra inne i sitt huvud. Det kallas anendophasia och AI har haft det fram tills nu. (Jag skrivit ett tidigare nyhetsbrev om det besläktade aphantasia, att en del människor inte kan visualisera saker inne i sitt huvud)

Alla är rörande överens om att AI-modellernas nyvunna förmåga att först ha en inre monolog innan svaren genereras är vägen framåt för att få svar av högre kvalitet med lägre grad av hallucinationer. Alla tester visar det.

Men när jag går igenom hur finetuning-exemplen ser ut för Sky-T1-32B-Preview så börjar jag förstå att sätten vi tränar upp hur en AI-modells inre monolog ska genereras kommer göra framtida AI-modeller för uppgiftsfokuserade. Jag ska förklara varför det är tokigt, men då behöver vi först lära oss om tre sätt som våra hjärnor fungerar på. Du kommer då också att förstå varför du behöver slappa på jobbet mer.

Om vi mäter vår hjärnaktivitet när vi aktivt löser ett specifikt problem så aktiveras ett gäng neuroner (noder) i vår hjärna. Dessa noder gillar att arbeta tillsammans så mycket att vi ser att det är ungefär samma varje gång vi fokuserar på att lösa en definierad uppgift. Hjärnforskare kallar den här gruppen noder för Central Executive Network eller CEN.

Fram till för runt 20 år sedan såg vi hjärnan som en prompt-baserad enhet. Den körde igång och genererade lösningar när det fanns problem som behövde lösas. Sedan började vi mäta vår hjärnaktivitet vid tillfällen då vi är avslappnade och inte aktivt löser problem. Då insåg vi att det fanns ett helt annat gäng neuroner som gillade att hänga tillsammans när vi inte hade gett vår hjärna några uppgifter. Den gruppen noder kallas för Default Mode Network eller DMN.

Det finns tydligare namn på dessa två nätverk – Task Positive Network och Task Negative Network, men det är inte de namnen som blivit populärast så vi kör på CEN och DMN idag.

Default Mode Network är riktigt bra på att komma på nya idéer och oväntade lösningar på problem vi inte behöver lösa. Det leker runt med omöjliga idéer och associerar fritt och det är alltså hjärnans läge som vi återvänder till när vi slappnar av, vårt default mode är att vara lekfulla och kreativa. Mindfulness, droger eller en dusch är yttre medvetna aktiviteter som forskare upptäckt kan hjälpa till att få hjärnan att gå från CEN till DMN-läge.

Det sista hjärnnodnätverket som jag tänker att vi behöver ha koll på innan jag kommer till poängen kallas Salience Node Network. Salience är ett svårt ord för uppmärksamhet, och vad den delen av hjärnan gör är helt enkelt att hålla koll på vår omgivning för att avgöra om vår hjärna just nu löser uppgifter och därmed borde använda CEN eller om vi kan återgå till att leka och därmed använda DMN.

Dagens teknik för resonerande AI återskapar bara förhållandena för aktiv fokuserad problemlösning. När de prompter som vi tränar AI på beskriver inre monolog som något som ska hålla sig inom ramarna (för att undvika osanningar) så återskapar vi motsvarigheten till CEN. Det är jättebra för att tänka rationellt, och det är spännande att vi kan få transformer-tech (LLM-baserade chatbottar) som egentligen bara är statistiska algoritmer för fri association att agera rationellt.

Styrkan i transformer-teknologin lämpar sig mer för att hitta på. Så genom att istället göra träningsprompter som fokuserar på hur en inre monolog ser ut för en människa som letar efter oväntade lösningar på problem skulle vi förmodligen kunna skapa artificiellt kreativt tänkande likt det vi använder när våra hjärnor är i default mode.

När vi människor fokuserar för hårt på problemlösning och CEN-delen av vår hjärna så hittar vi snabba lösningar men vi blir stressade, utbrända och lösningarna blir även om de är på hög nivå generiska. För att bli en bra problemlösare behövs att vi klarar av att formulera om problem utanför instruktionen (prompten). Tid för ifrågasättande av uppgiften krävs och det allra bästa är om vi kan få Salience Node Network att tolka uppgiften mer som lek än som uppgift så DMN kickar in.

Jag tror därför att vi kommer se att nästa generations AI-modeller (LLMs) blir väldigt mycket duktigare på att lösa rationella problem, men bara där det finns tydliga definierade sanningar som de kan bygga kedjor av. Det leder till kompetent men generisk slutledningsförmåga.

Utmaningen för oss alla är att förstå och uppskatta att våra hjärnor behöver ha kul och leka för att komma på intressanta nya lösningar. För om vi lär oss mer om hur vi själva kan försätta oss i default mode så kan vi sedan bygga AI som klarar kreativ problemlösning och detta förändrar ju allt!

Vad kan du göra idag?

Förstå

Förståelsen av hur människans hjärna fungerar är under utveckling. När jag var liten pratade vi om att höger hjärnhalva styrde kreativitet och vänster hjärnhalva styrde logik, vilket inte är sant. Det var på grund av att Roger W. Sperry fått Nobelpris för sina studier där han studerade människor som bokstavligt hade fått sina hjärnor uppdelade i höger och vänster. Personerna han studerade hade avskurna ledningar mellan de hjärnhalvorna. I normalfall arbetar de båda hjärnhalvorna ihop i alla uppgifter.

Idag har vi istället fMRI som visar vilka delar av hjärnan som aktiveras när vi tänker. Det är inte säkert att DMN och CEN kommer att vara de slutliga modellerna för att förklara hur våra hjärnor fungerar, men de bygger på mätningar av människor där båda delarna av hjärnan sitter ihop.

Studier visar att personer som är i default mode löser kreativa uppgifter bättre, och i en studie från förra året där forskare manipulerade försökpersonernas hjärnor och dämpade aktiviteten i DMN-delarna så visade det sig att dessa personer hade mycket sämre resultat på kreativitetstester.

Om du förstår hur din hjärna (närmare bestämt Salience Node Network) sorterar vad som är en målstyrd uppgift och vad som får vara lek så kan du aktivt få din hjärna att arbeta mer kreativt med fler typer av uppgifter.

Planera

Det är inte så länge sedan jag skrev att även mindre organisationer snart har råd att träna sina egna versioner av AI. Med prislappar som Sky T1 uppvisar så kryper tiden närmare tills alla som vill ha en specialtränad AI på just deras organisations problem kommer att ha det.

Då skrev jag att varje organisation behöver skapa ett dataset med träningsdata enligt följande:

Skriv frågor som ni vill kunna ställa till er AI.

Skriv svaren som ni vill att er AI skulle ha gett er och motivera varför det är korrekt svar. Ni måste också tänka igenom så det finns tillräckligt med frågor där det finns ett tydligt rätt svar, men också frågor där svaret inte går att få fram, och frågor i gråzonen däremellan.

Men med de nya tänkande modellerna så behöver vi uppdatera:

Skriv frågor som ni vill kunna ställa till er AI.

Skriv inre monolog som beskriver hur ni skulle tänka om ni fick den här frågan.

Skriv svaren som ni vill att er AI skulle ha gett er baserat på frågan i kombination med den inre monologen och motivera varför det är ett korrekt svar. Ni måste också tänka igenom så det finns tillräckligt med frågor där det finns ett tydligt rätt svar, men också frågor där svaret inte går att få fram, och frågor i gråzonen däremellan.

Inte för att jag vill få era hjärnor att gå in i CEN-läge men om ni inte ens har börjat så är det viss tidspress nu, för det kommer ta tid att göra ett bra dataset för träning. Längre tid än det är kvar innan det är möjligt. Se till att ni är redo.

Gör

Ju mer vi lär oss om hur AI fungerar desto viktigare blir det att förstå hur vi själva fungerar. AI-träningen av modeller som Sky T1, ChatGPT o3 och Google Gemini 2.0 Flash Thinking baseras på hur ett fåtal personer formulerar hur en inre monolog leder till svar. Det kommer finnas utrymme för många fler människors sätt att ha inre monolog, så det kommer bli viktigare att kartlägga hur olika typer av inre monolog kan leda till olika svar.

Veckans Gör blir därför att kartlägga hur din egna inre monolog ser ut när du tänker. Prata högt för dig själv när du löser en uppgift. Är du en sådan person som kommer på lösningen när du försöker formulera vad du gör, eller dyker lösningen mer upp som en associativ idé?

Vad tror du skulle hända om ChatGPTs inre monolog vore mer som din egna, skulle svaren bli annorlunda?

Länkar

Vetenskaplig genomgång av forskningen kring DMN

https://www.sciencedirect.com/science/article/pii/S0896627323003082

Presentation av modellen Sky-T1.

https://novasky-ai.github.io/posts/sky-t1/

Här finns dataset

https://huggingface.co/NovaSky-AI

Studie som visar att mer aktivitet i DMN ger fler kreativa ideer

https://neurosciencenews.com/creativity-dmn-neuroscience-26436

Sedan sist vi hördes

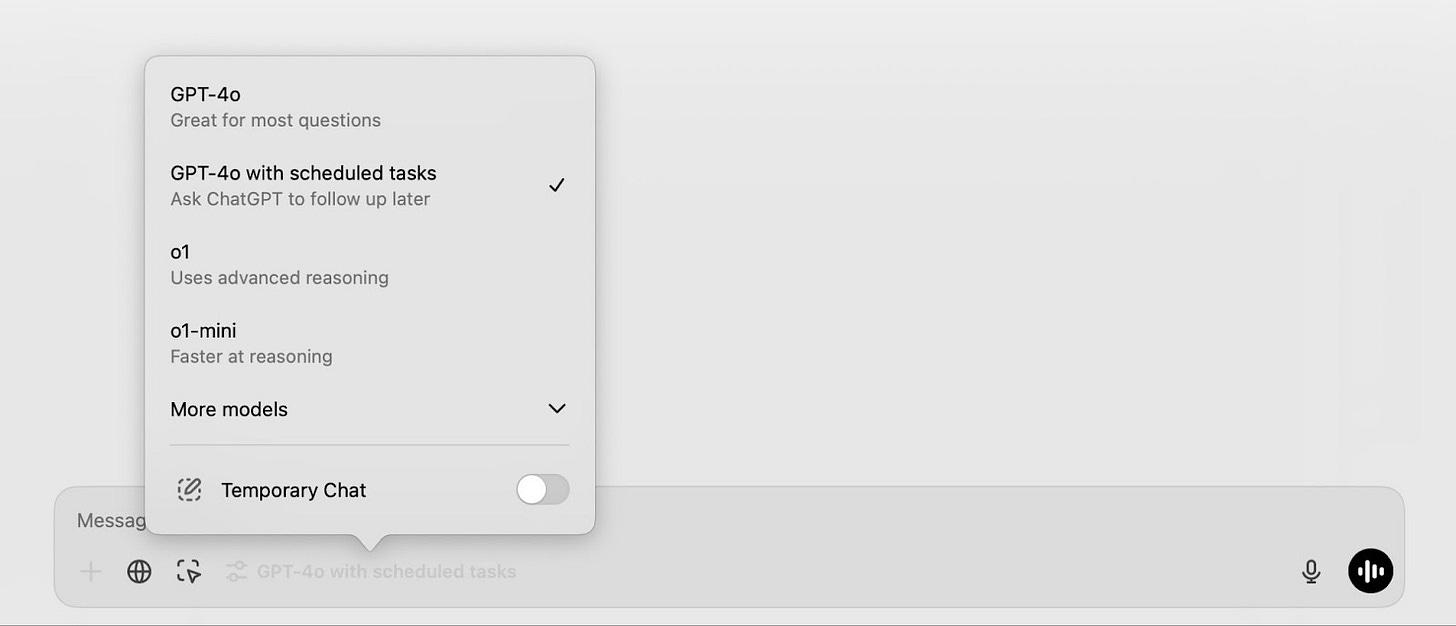

I förra nyhetsbrevet skrev jag ju att det ryktades att OpenAI skulle släppa tidsinställda prompter. Nu är de här för betalande. Du kan nå det genom att välja GPT-40 with scheduled tasks som modell. Sedan kan du be ChatGPT ställa in en reminder eller återkommande task. Jag fick det alldeles nyss så jag har inte hunnit experimentera så mycket med det.

Än så länge har jag inte sett någon som gjort något oväntat. De mest användbara exemplen jag sett är att sammanfatta nyheter dagligen. Så min tanke är att se vilka nyhetssajter jag skulle kunna kombinera ihop (som tillåter det) och sedan be om en daglig analys av vilka nyheter som trendar. Men hittills har jag inte fått till det i en prompt som fungerar tillfredsställande.

Är du en insiktsdelare?

Känner du någon som gillar att optimera sin kreativitet? Eller kanske någon som behöver förstå mer om hur vi kan specialisera AI-modeller genom fine tuning av deras inre monolog? Vem tänkte du på? Skicka vidare!

Dagens nyhetsbrev är inspirerat av den här intervjun med Annaka Harris som beskriver en ganska filosofisk syn på hur ”jaget” inte existerar utan bara är en liten del av universum.

Om du ser den och ser den här strax efter så blir det extra roligt.

Just nu letar jag efter nya uppdrag så behöver du strategisk rådgivning i frågor kring AI eller marknadsföring är det bara att höra av dig. Här är min Linkedin om du vill se mer om vad jag har gjort tidigare.

Fortsätt utforska så ses vi nästa vecka!

Tomas Seo

Har du fått dagens nyhetsbrev utan att vara prenumerant?

Gillade du det här och vill ha mer så är det bara att skriva upp sig här

(du väljer själv om du vill betala):